علت خطای Submitted URL has crawl issue در سرچ کنسول و رفع آن

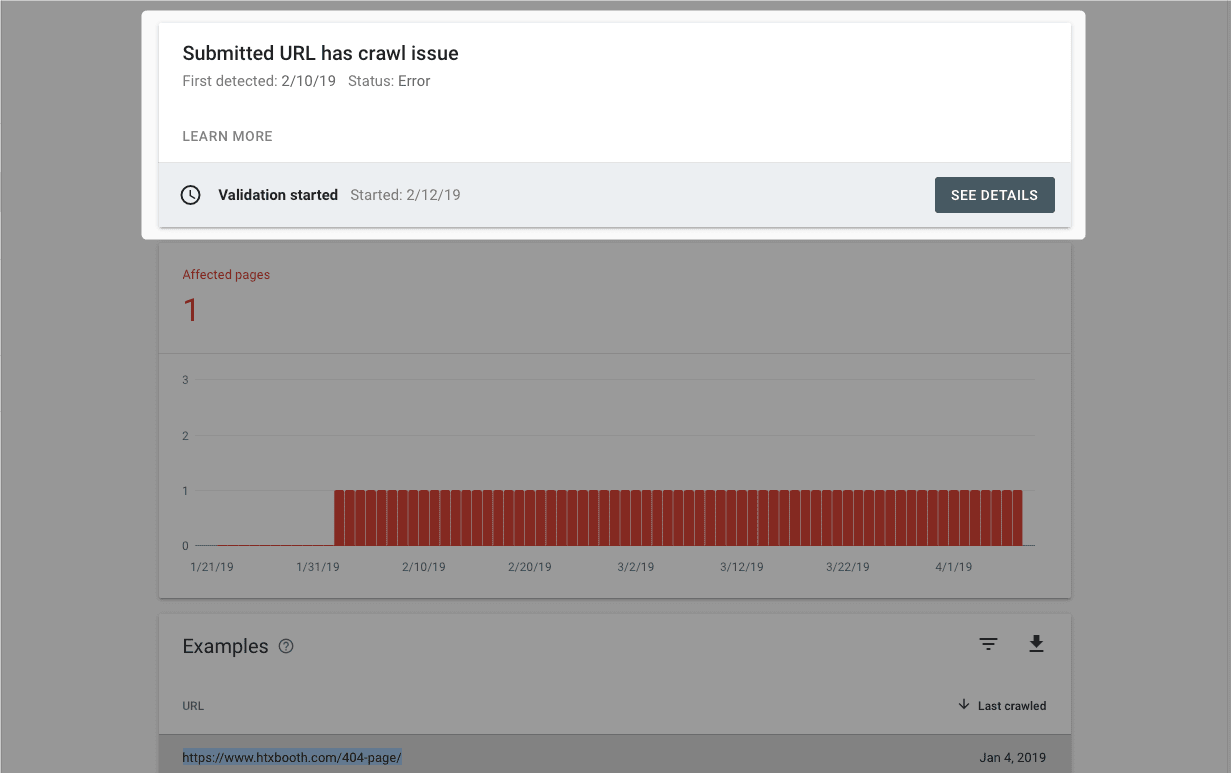

خطای Submitted URL has crawl issue در سرچ کنسول یکی از خطاهای پیچیدهست که ممکنه دلایل زیادی داشته باشه. این خطا زمانی در گزارش Pages ظاهر میشه که صفحه ای رو برای ایندکس شدن در سایت مپ قرار داده باشید، اما ربات های گوگل در زمان خزش به مشکلی خورده باشن و نتونسته باشن URL رو بخزن. در ادامه این بخش از آموزش سرچ کنسول با این ارور گوگل سرچ کنسول بیشتر آشنا میشیم و بهتون میگیم برای رفعش باید چکارهایی کنید.

علت خطای Submitted URL has crawl issue در سرچ کنسول چیست؟

این ارور یکی از موارد پیچیده در لیست ارور سرچ کنسول هست و همون طور که اشاره کردیم سرچ کنسول برای این خطا، هیچ راهنمایی مفیدی برامون نداره. فقط از عبارت Submitted URL می تونیم بفهمیم این ارور برای URLهایی که در فایل نقشه سایت (Sitemap) ارسال کردیم، اتفاق افتاده. این که چرا ربات های گوگل نتونستن صفحه رو کراول کنن یا بخزن، ممکنه دلایل مختلفی داشته باشه. 🤔

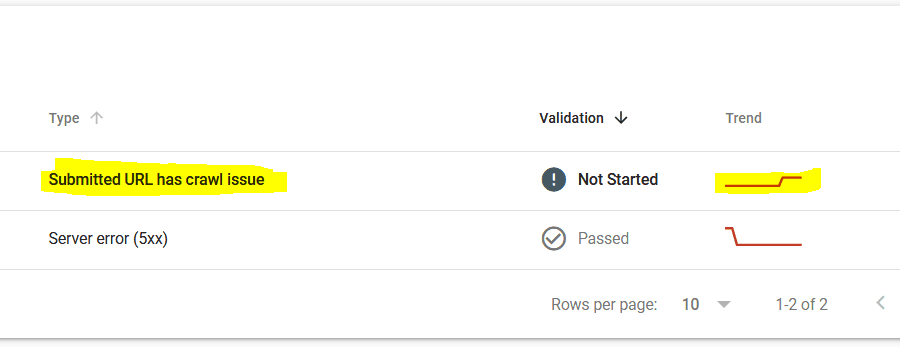

اما خوشبختانه این دلیل، چیز پیچیده ای نیست و خیلی از اوقات وقتی این پیغام رو در جدول بخش Pages دیدید، کافیه با ابزار URL Inspection، تست Live URL رو انجام بدید. اگه تست، مشکلی از نظر خزیدن ربات ها نشون نمیداد، ارور خودش برطرف میشه.

البته اگه این خطا بعد از چند روز که تاریخ کراول ربات های گوگل (Last crawled) بهروز شد، همچنان به قوت خودش باقی بود، باید دست به کار بشید.

معمولا هر دلیلی که جلوی خزیدن ربات ها رو بگیره، می تونه این خطا رو در جدول بخش Pages سرچ کنسول ایجاد کنه. پس مطمئن بشید که صفحات دارای این خطا از طریق فایل robots.txt مسدود نشدن و تگ نو ایندکس هم در این صفحات به کار نرفته.

حتی مشکلاتی مثل ریدایرکت های اشتباه یا طولانی هم ممکنه ربات های گوگل رو از خزیدن منصرف کنن. صفحاتی که از ریدایرکت های جاوا اسکریپت استفاده می کنن تا کاربرها با توجه به موقعیت مکانیشون به نسخه مناسب تر سایت هدایت بشن، به احتمال خیلی زیاد با ارور Submitted URL has crawl issue در سرچ کنسول مواجه میشن.

راه رفع خطای Submitted URL has crawl issue در سرچ کنسول چیست؟

برای برطرف کردن این خطا باید ببینید چه احتمالاتی این مشکل رو ایجاد کردن. اول از همه مسدودیت ربات های گوگل رو چه از طریق تگ نو ایندکس و چه فایل robots.txt بررسی کنید.

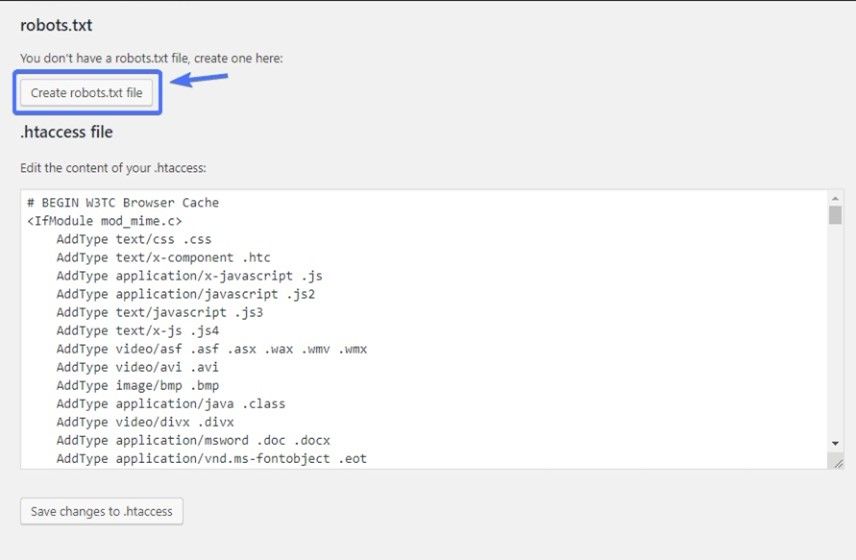

برای بررسی فایل robots.txt در سایت های وردپرسی میشه از افزونه های سئو مثل یوآست و رنک مث استفاده کرد. از طریق منوی پیشخوان وردپرس برای استفاده از افزونه یوآست، گزینه سئو و بعد ابزارها رو انتخاب کنید. بعد گزینه ویرایشگر فایل رو انتخاب کنید تا فایل robots.txt موجود نشون داده بشه. اگه مقدار Disallow برای User-agent: Googlebot توی این فایل وجود داشت، حتما با مشورت سئوکار باتجربه، فایل رو ویرایش کنید.

در ضمن بهتره برای اینکه دقیقا بفهمید مشکل خزیدن ربات ها از کجا آب می خوره، از طریق ابزارهای سئو، صفحات سایت رو بازرسی کنید.

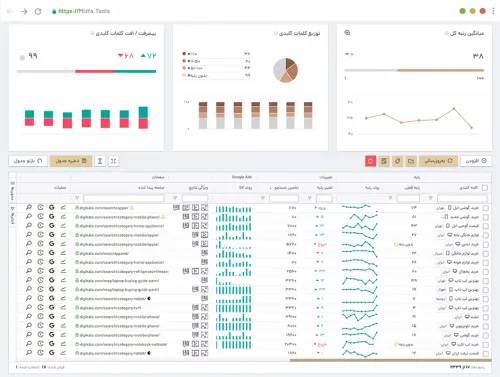

ابزار خزش سایت میزفا تولز رو برای همین کار طراحی کردیم تا خطاهای سئو سایت رو بهتون نشون بده. با این ابزار می تونید تمام صفحات سایت رو در اختیار ربات های میزفا تولز قرار بدید تا کراول کنن و مشکلات مهم سایت رو پیدا کنن. در نهایت نتیجه خزش رو در قالب یک گزارش کامل می بینید و خطاهای مهم، هشدارها و اطلاعیه ها بهتون میگن چه مشکلی مانع از خزیدن ربات های گوگل در سایت شما میشه. 😼

برای استفاده از 8 ابزار سئو در میزفا تولز، کافیه توی سایت ثبت نام کنید تا فرصت استفاده رایگان 7 روزه برای شما فعال بشه. بهتره این فرصت رو از دست ندید.😉

سایت رو هنوز برای گوگل سئو نکردم.

سایت برای موتورهای جستجو باز نیست.