چگونه خطاهای خزیدن Crawl Errors را در سرچ کنسول برطرف کنم؟

خطاهای Crawl Errors در سرچ کنسول، خطاهایی هستن که در زمان کراول یا خزش ربات های گوگل اتفاق افتادن. از اونجایی که ایندکس شدن صفحات و بعد از اون رتبه بندی در نتایج جستجو، همگی وابسته به خزیدن ربات های گوگله، هر مانعی که برای این ربات ها وجود داشته باشه خیلی مهمه و باید هرچی زودتر این موانع رو برطرف کنیم. برای رفع خطاهای Crawl Errors اول باید ببینیم چه خطاهایی ممکنه در زمان کراول ربات ها اتفاق بیفته تا بعدش بفهمیم چگونه خطاهای خزیدن Crawl Errors را در سرچ کنسول برطرف کنم.

توی این بخش از آموزش سرچ کنسول قراره ببینیم Crawl Errors چیست و چطور باید رفعشون کرد. پس همراه تیم میزفاتولز باشید.

Crawl Errors چیست؟ | خطاهای Crawl Errors در سرچ کنسول

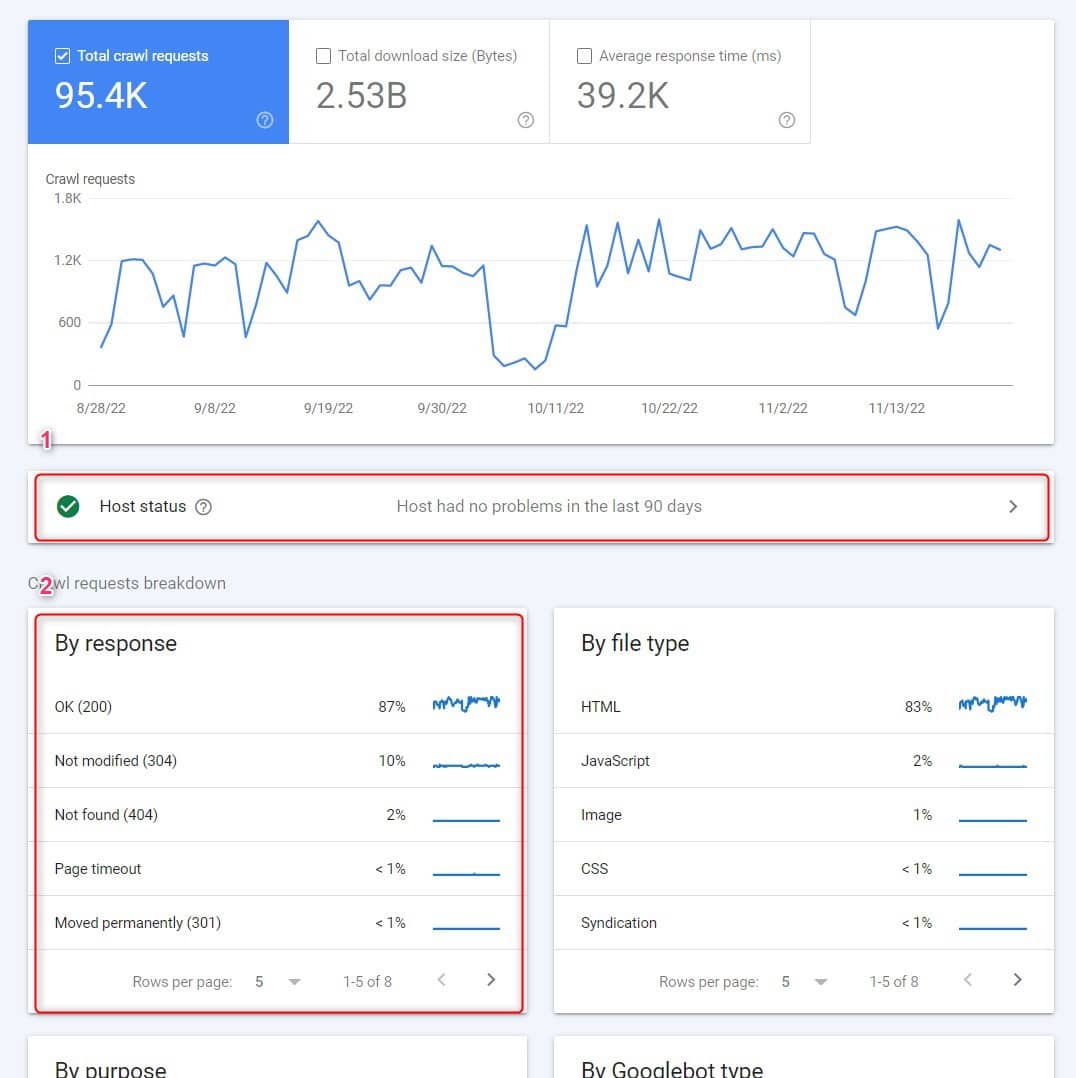

در مقاله قبلی سرچ کنسول که درباره بخش Settings یا تنظیمات سرچ کنسول بود به سراغ گزارش Crawl stats یا آمار خزیدن رفتیم. اگه مقاله قبلی رو نخوندید بهتره اول با این گزارش آشنا بشید، چون خطاهای کراول رو توی این گزارش می تونیم ببینیم.

این خطاها، مشکلاتی از سایت ما هستن که ربات های گوگل پیدا کردن؛ ممکنه این خطاها بعد از ایندکس شدن صفحه و توی خزیدن های مجدد پیدا شده باشه یا توی همون اولین خزش، مانعی وجود داشته باشه. این خطاها بیشتر از جنس خطاهای مربوط به DNS و خطاهای مربوط به سرور هستن. به جز این دوتا مشکلات مربوط به فایل robots.txt هم ممکنه در زمان کراول وجود داشته باشه. 🕷

یه تعدادی از این خطاها رو می تونید توی گزارش Pages (همون Coverage سابق) هم ببینید؛ اما توی گزارش Crawl stats به صورت کامل تر به این خطاها دسترسی دارید. در ادامه ما خطاهایی رو که ممکنه در Crawl stats ببینید، بررسی می کنیم.

رفع خطاهای Crawl Errors سرچ کنسول

برای پیدا کردن خطاها در گزارش Crawl stats دو قسمت هست که باید بررسی کنید:

🔸 Host status

🔸 By response

رفع خطاهای کراول در Host status گزارش Crawl stats

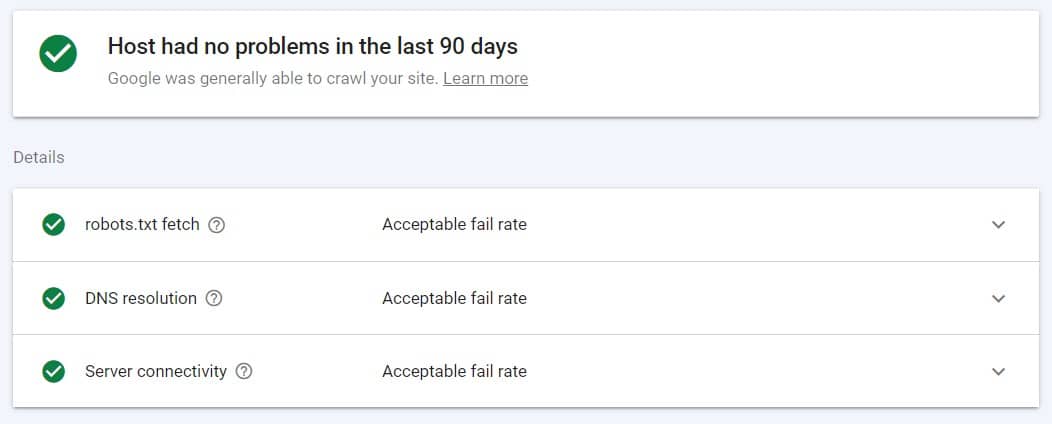

Host status یا وضعیت هاست که در زیر نمودار آمار خزیدن قرار داره، وضعیت هاست رو در زمان ریکوئست ربات های گوگل برای کراول بررسی می کنه. ربات های گوگل با بررسی 3 پارامتر مهم وضعیت هاست رو بررسی می کنن:

👈 واکشی یا فچ فایل robots.txt (robots.txt fetch)

👈 DNS رزولوشن (DNS resolution)

👈 وضعیت اتصال سرور (Server connectivity)

برای این 3 پارامتر، 3 نمودار در بخش Host status وجود داره که خط روی نمودار، خطای مربوط به هر کدوم از پارامترها رو نشون میده. مثلا در نمودار رزولوشن DNS، محور افقی روزهای مختلف رو نشون میده و محور عمودی مربوط به خطای DNS resolution. پس در بهترین حالت، خط نمودارها در این بخش باید به صفر نزدیک باشه و از صفر جدا نشه. اینجوری میشه گفت خطا صفر بوده.

نکته بعدی مربوط به آیکن کنار این 3 پارامتر هست:

✅ در بهترین حالت باید کنار هر سه پارامتر «تیک سبز» دیده بشه که یعنی هیچ مشکلی در 90 روز گذشته وجود نداشته.

✔ اگه «تیک سفید» وجود داشت، یعنی در 90 روز گذشته یه مشکلی پیدا شده؛ اما مشکل مربوط به هفته پیش نیست و ممکنه رفع شده باشه.

❗ «علامت تعجب قرمز» کنار این پارامترها یعنی باید به فکر رفع خطا باشید، چون توی 7 روز گذشته مشکل پیدا شده.

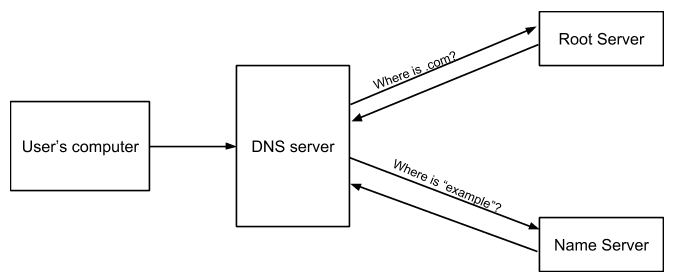

❌ خطای DNS ❌

DNS یا domain name system یک سرویسه که به ما اجازه میده به جای وارد کردن آدرس IP هر سایت در مرورگر، دامنه سایت رو وارد کنیم و به صفحه مقصدمون برسیم. در واقع DNS میاد آدرس IP سایت رو به حروف و اعداد تبدیل می کنه. منظور از DNS resolution در بخش Host status هم همون پروسه یا روندیه که آدرس IP سایت به نام دامنه تبدیل میشه.

اولین چیزی که لازمه درست کار کنه تا ربات های گوگل به مرحله خزیدن سایت برسن، سلامت یا اتصال DNS هست. خطاهایی که روی نمودار این پارامتر دیده میشه زمانی رو نشون میده که گوگل بات ریکوئست فرستاده و سرور DNS نتونسته نام هاست رو بشناسه؛ یا اینکه اصلا پاسخی نداده. در واقع هر زمانی که سایت ما با سرور DNS ارتباط برقرار نکنه، خطای DNS رخ میده. 😥

برای رفع این خطا روند مشکلات DNS رو در نمودار دنبال کنید. پاسخ های 500 و 404 هم ممکنه به عنوان خطای DNS گزارش بشه. در نهایت اگه مشکل ادامه داشت بهتره با خدمات هاست خودتون ارتباط برقرار کنید تا مشکلی در راه اندازی سرور DNS یا پیکربندی DNS وجود نداشته باشه.

❌ خطاهای سرور یا Server Errors ❌

خطای سرور وقتی اتفاق میفته که گوگل بات ها در ریکوئست به سرور DNS پاسخ موفق گرفتن؛ اما مشکلی توی سرور وجود داره که ربات ها نتونستن به URL دسترسی پیدا کنن. ممکنه سایت شما شلوغ بوده باشه؛ ممکنه ریکوئست Timed out شده باشه یا موارد دیگه.

نمودار خطای اتصال یا در دسترس بودن سرور رو بررسی کنید. اگه نمودار در تاریخ های زیادی از خط صفر دور شده، بهتره به دنبال خدمات هاست باکیفیت تری باشید.

مشکلات سرور می تونه به دلایل دیگه هم باشه. مثلا اگه توی سایتتون برای چندین URL، محتوای یکسان وجود داشته باشه و پارامترهای URL طولانی باشن، ممکنه این صفحات بیش از حد طول بکشه که پاسخ بدن و خطای Timed out اتفاق بیفته. سرور DNS، سیستم مدیریت محتوا، فایروال یا سیستم های حفاظتی اگه به درستی پیکربندی نشن می تونن باعث مشکل در اتصال سرور بشن. ⛔

پیکربندی سیستم های حفاظتی خیلی مهمه و یکی از رایج ترین خطاهای Crawl Errors در سرچ کنسول محسوب میشه. از اونجایی که گوگل بات ها نسبت به کاربر انسانی ریکوئست بیشتری به سایت میفرستن، می تونه باعث فعال شدن سیستم های حفاظتی بشه و دسترسی گوگل بات ها به سرور قطع بشه.

❌ خطای Robots failure ❌

نمودار robots.txt fetch، ریکوئست هایی که گوگل بات ها در روزهای مختلف به هاست یا سرور ارسال کردن رو نشون میده. هر زمان پاسخ هاست مشکلی نداشته باشه، نمودار روی خط صفر جلو میره. 2 پاسخ معتبر از نظر گوگل بات ها برای فایل robots.txt وجود داره:

✔ HTTP 200 – یک فایل معتبر وجود داره؛ فارغ از پر یا خالی بودن یا حتی خطاهای دستوری موجود در فایل.

✔ HTTP 403/404/410 – فایل وجود ندارد.

اگه غیر از این دو، پاسخ دیگه ای موقع ریکوئست فایل دریافت بشه، گوگل بات ها خزیدن سایت رو متوقف می کنن. ربات های گوگل برای درخواست این فایل ابتدا بررسی می کنن که آیا ریکوئست مربوط به robots.txt در کمتر از 24 ساعت گذشته وجود داره یا نه.

اگه آخرین پاسخ ریکوئست این فایل ناموفق باشه، ریکوئست دوباره صادر میشه. اگه این بار موفق بود، کراول یا خزیدن ربات ها شروع میشه. اگه موفق نبود؛ تا 12 ساعت همچنان ریکوئست این فایل می مونه و خزیدن سایت متوقف میشه.

از اونجایی که هر خطایی مربوط به robots.txt می تونه کراول سایت رو متوقف کنه؛ خیلی مهمه که خطاهای مربوط به این فایل رو جدی بگیرید. واکشی یا فچ فایل robots.txt بعد از DNS و ارتباط با سرور، سومین قدم یا پل محسوب میشه که برای کراول ربات ها لازمه. 🕷

برای رفع خطاهای Crawl Errors مربوط به robots، حتما این فایل رو بررسی کنید تا دستوری به اشتباه در فایل ثبت نشده باشه. این فایل رفتار موتورهای جستجو رو در سایت شما رو تعیین می کنه و اگه به اشتباه جلوی گوگل بات ها رو گرفته باشید، آسیب جدی برای رتبه سایت داره.

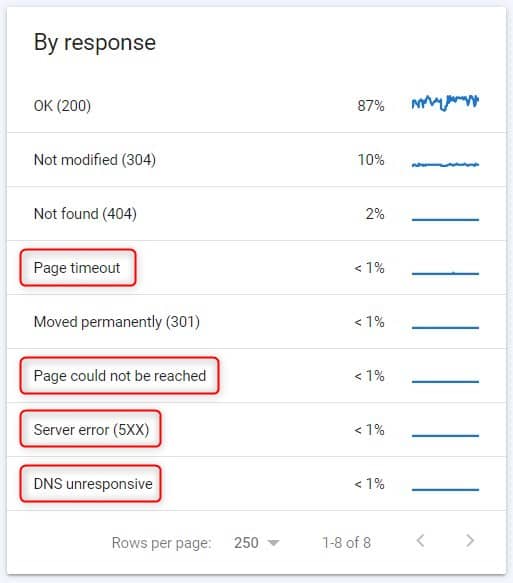

رفع خطاهای کراول در جدول By response گزارش Crawl stats

برای کامل کردن پاسخ پرسش «چگونه خطاهای خزیدن Crawl Errors را در سرچ کنسول برطرف کنم» باید به سراغ یکی دیگه از بخش های گزارش Crawl stats هم بریم. در یکی از جدول های این گزارش که داده ها بر اساس نوع پاسخ (By response) گروه بندی شدن، می تونید خیلی از مشکلات و خطاهای کراول رو پیدا کنید.

اول اینکه از پایین این جدول، گزینه Rows per page دیده میشه که از طریق عدد جلوی این گزینه می تونید ردیف های جدول رو بیشتر کنید تا گروه بندی داده ها رو کامل تر ببیند. بعد از این کار باید بریم سراغ پاسخ هایی که یکسری از URLهای سایت در زمان کراول گوگل بات ها برگردوندن و پاسخ های خوبی نیستن. ❌

روی هر ردیف از جدول By response که کلیک کنید وارد صفحه مربوط به URLهایی که اون پاسخ رو برگردوندن، میشید. البته همه URLهایی که یک پاسخ خاص رو برگردوندن جمع آوری نشده و یک سری از URLها به عنوان Examples یا نمونه در اختیارتون قرار داره.

در زیر پاسخ هایی که برای وضعیت سایت خوب نیست و به نوعی خطای Crawl Errors محسوب میشه رو بررسی می کنیم.

❌ robots.txt not available ❌

این خطا نشون میده فایل robots.txt در دسترس نیست و همون اتفاقی که بالاتر توضیح دادیم میفته؛ یعنی ربات ها خزیدن رو متوقف می کنن تا پاسخ معتبری از صفحات برگرده.

❌ Unauthorized (401/407) ❌

صفحاتی که این کدها رو برمی گردونن یا باید از طریق فایل robots.txt مسدود بشن یا تصمیم بگیرید که مسدودیت رو بردارید تا تبدیل به صفحات عادی (200) بشن. در هر صورت این کدها نشون میده که ورود گوگل بات ها به این صفحات مجاز نیست و برای ورود به اونها نیاز به مجوزه. (مثل صفحه ورود به سایت)

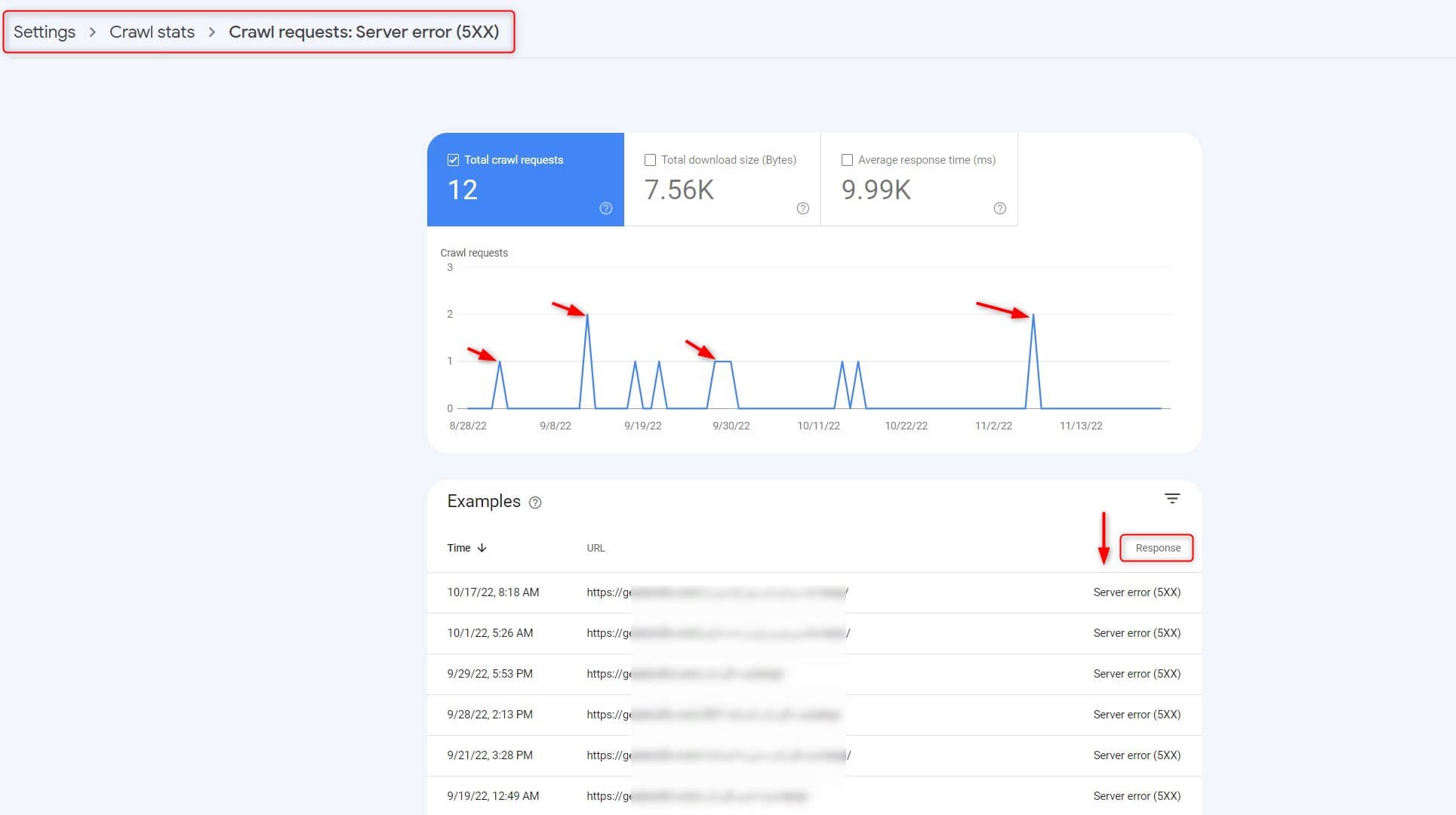

❌ Server error (5XX) ❌

خطاهای مربوط به سرور از مهم ترین خطاهای Crawl Errors هستن که می تونه دلایل مختلفی باعث این خطا بشه. اگه از خدمات سرور سایت مطمئن هستید، می تونید بودجه خزش سایت رو بررسی کنید. گاهی نرخ خزش بالای روی برخی از سایت ها ممکنه باعث خطاهای سروری بشه.

❌ Other client error (4XX) ❌

این خطا مربوط به خطاهای خانواده 4XX هست که البته در سمت کلاینت اتفاق افتاده.

❌ DNS unresponsive ❌

این خطا داره میگه سرور DNS پاسخگو نیست و به ریکوئست هایی که از سمت گوگل بات ها فرستاده میشه، پاسخی نمیده. برای رفع این مشکل نکاتی که بالاتر گفتیم رو در نظر داشته باشید. 🤓

❌ DNS error ❌

خطای DNS Error وقتی ظاهر میشه که مشکل مربوط به DNS شناسایی نشده باشه. وقتی دیدید یکسری از URLها این خطا رو بر می گردونن باید هر چیزی که مربوط به DNS میشه رو بررسی کنید.

❌ Fetch error ❌

خطاهای مربوط به فچ یا واکشی URLها توی این گروه دسته بندی میشه. URLهایی که با این خطا برچسب خوردن رو از طریق ابزار URL Inspection بررسی کنید تا متوجه بشید چه چیزی مانع فچ صفحات میشه. معمولا شماره پورت نامناسب، آدرس IP یا پاسخ غیر قابل تحلیل باعث این خطا میشه.

❌ Page could not be reached ❌

این خطا داره میگه ربات های گوگل به صفحه نرسیدن. این اتفاق معمولا زمانی رخ میده که مشکلاتی در بازیابی صفحه وجود داشته باشه و ریکوئست ها تکمیل نشن. چون ریکوئست ها تکمیل نشدن اونها رو در گزارش سرور نمی بینید، اما در گزارش Crawl stats سرچ کنسول می تونید نمونه URLهایی که این مشکل رو دارن بررسی کنید.

❌ Page timeout ❌

این خطا می تونه یکی از خطاهای سرور یا DNS باشه که وقتی زمان ریکوئست تموم میشه، برمیگرده. برای رفع این خطا باید به سراغ مشکلات سرور و DNS برید. هر وقفه ای که در ارتباط رخ بده، این خطا رو بر می گردونه.

❌ Redirect error ❌

این خطا مربوط به URLهاییه که از ریدایرکت های لوپ و دایره ای استفاده می کنند. هر موقع تغییر مسیرها زیاد باشه یا ربات ها توی یک چرخه ریدایرکت گیر بیفتن، این خطا مشاهده میشه.

مهم ترین خطاهای Crawl Errors چیست؟

بین خطاهایی که بالاتر توضیح دادیم، خطای مربوط به فایل robots.txt و خطاهای سروری اهمیت خیلی زیادی دارن. 🧐

خطاهای سروری که کلا ارتباط گوگل بات ها با سایت رو قطع می کنن؛ پس قبل از هرچیزی مشکلات سروری باید برطرف بشه. این مشکلات ممکنه از خدمات هاست شما باشه یا پیکربندی های اشتباهی که بالاتر اشاره کردیم. بهتره پایداری سرور رو به کمک ابزارهای مختلف زیر نظر داشته باشید و اگه مشکلی از سمت هاست وجود نداشت به سراغ پیکربندی سیستم مدیریت محتوا و فایروال برید.

بعد از خطاهای سروری باید به سراغ خطاهای مربوط به فچ فایل robots.txt برید. همون طور که بالاتر هم گفتیم تا زمانی که گوگل بات ها نتونن به این فایل دسترسی داشته باشن از کراول کردن سایت دست بر می دارن.

برای رفع خطاهای Crawl Errors اول از همه باید بتونید لیست تمام صفحاتی که کدهای نامناسب مثل 5XX یا 4XX برمی گردونن رو پیدا کنید. متاسفانه در سرچ کنسول به همه این URLها دسترسی ندارید؛ پس راهی نیست جز استفاده از ابزارهای سئو. 😼

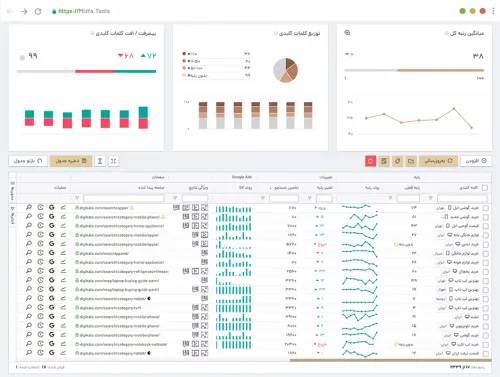

برای اینکه گزارش کاملی از خزیدن ربات ها روی سایت خودتون داشته باشید می تونید از میزفا تولز استفاده کنید. ابزار سئو ایرانی میزفا تولز از چندین ابزار مختلف تشکیل شده که شما رو برای بهبود سئو سایت همراهی می کنه.

ابزار خزش سایت میزفا تولز تمام صفحات سایت شما رو می خزه و هر خطا و نکته ای که لازم باشه رو به صورت کامل بهتون گزارش میده. با میزفا تولز می تونید هر زمان که خواستید ربات های خزنده رو به سراغ سایت بفرستید تا مطمئن بشید مشکلی وجود نداره. تصویر زیر نمای گزارش بعد از خزش سایته که تمام نکات مهم به صورت دسته بندی شده در اختیار شما قرار می گیره.

اگه می خواید خطاهای سئو سایت خودتون رو شناسایی کنید یا برای تولید محتوا نیاز به تحقیق کلمات کلیدی و سئو محتوا دارید، میزفا تولز همه اینها رو در قالب یک ابزار در اختیارتون قرار میده. می تونید تا 7 روز به صورت رایگان از میزفا تولز استفاده کنید و با بخش های مختلفش آشنا بشید.

برای بررسی خطاهای مربوط به DNS از چه گزارشی در سرچ کنسول استفاده کنیم؟

گزارش Pages یا Coverage

گزارش Crawl stats