عمق خزش چیست و چطور Crawl Depth رو بررسی کنیم؟

امروزه تعداد محتواها در وبسایتها خیلی زیاد شده و حجم مطالبی که باید ایندکس بشن داره هر روز بیشتر میشه. پای هوش مصنوعی هم که بهمیان اومده و کنار جستجوی سنتی توی موتورهای جستجو، جستجو از طریق مدلهای زبانی بزرگ (LLMها) هم وارد زندگی روزمرهمون شده.

حتی اگه فعلا این مدلها بهصورت فنی موتور جستجو محسوب نشن، وبسایتها باید خودشون رو با چتباتهای مبتنی بر LLM، مثل ChatGPT، Gemini، Perplexity، Claude و بقیه، سازگار کنن تا محتواشون قابل دسترس باشه.

حالا اگر میخواین سایتتون هم توسط موتورهای جستجو خزیده بشه و هم محتواهای مهمتون ایندکس بشه، تمرکز اصلی مدیر سئو و متخصصین باید روی افزایش بهرهوری خزش باشه. و یکی از مهمترین فاکتورها برای این کار، عمق خزش (Crawl Depth) هست که قراره توی این مقاله مفصل بهش بپردازیم.

عمق خزش (Crawl Depth) چیه؟

اگه بخوام ساده بگم، عمق خزش یعنی یه صفحه توی ساختار سایتت چقدر از صفحه اصلی فاصله داره.

بهعبارتی، چند تا کلیک لازمه تا از Homepage برسی به اون صفحه خاص؟

مثلا فرض کن ساختار سایتت اینطوریه:

صفحه اصلی (Homepage) ← دسته A (Category A) ← زیردسته A1 (Subcategory A1) ← صفحه محصول (Page 1)

اینجا:

- صفحه اصلی در عمق ۰ قرار داره (نقطه شروع).

- دسته A در عمق ۱ قرار داره.

- زیردسته A1 در عمق ۲ قرار داره.

- و صفحه محصول در عمق ۳ قرار گرفته.

پس هرچی فاصله یا عمق یه صفحه از صفحه اصلی بیشتر باشه، رسیدن بهش برای رباتهای گوگل سختتر میشه.

از دید فنی و سئویی عمق خزش به چه مفهومه؟

از نظر فنی، عمق خزش (Crawl Depth) نشون میده که رباتهای موتور جستجو و حتی موتورهای پاسخگو (که با LLM کار میکنن) طی یک خزش، تا چه عمقی از سایت پیش رفتن و چند تا از صفحات رو بازدید و ایندکس کردن.

وقتی عمق خزش سایت بالاست، یعنی گوگل تونسته تعداد بیشتری از صفحاتت رو ببینه و ایندکس کنه.

اما اگه عمق خزش پایین باشه، ممکنه بخش زیادی از صفحات سایتت اصلا ایندکس نشن یا با تأخیر زیاد ایندکس بشن.

چرا عمق خزش مهمه؟

عمق خزش مستقیما به ساختار سایت (Site Architecture) مربوطه.

اگه ساختار سایتت منطقی و درست طراحی شده باشه، گوگل خیلی راحتتر میتونه از صفحه اصلی به صفحات داخلی برسه.

برای اینکه بهتر درک کنیم، یه مثال واقعی بزنیم 👇

فرض کن تازه میخوای ساختار لینک سازی سایت فروشگاهیت رو انجام بدی. نقطه شروع همه کاربرها صفحه اصلی (Homepage) هست. حالا سؤال اینه:

کاربر برای رسیدن به صفحهای که میخوای دیده بشه، مثلا محصول خاصی مثل لپتاپ ایسوس باید چند تا کلیک انجام بده؟

در حالت ایدهآل، صفحاتی که اهمیت بالایی دارن مثل دستهبندیها یا محصولات جدید نباید بیشتر از ۲ یا ۳ کلیک با صفحه اصلی فاصله داشته باشن.

مثلا:

← وارد صفحه اصلی میشی

← روی بنر لپتاپ ایسوس کلیک میکنی

← مستقیم میری به صفحه مخصوص لپتاپ ایسوسها

← و نهایتا با یه کلیک دیگه وارد صفحه دقیق محصول میشی

یعنی فقط ۲ تا کلیک تا رسیدن به هدف.

حالا اگه همین محصول ۳ یا ۴ لایه پایینتر پنهون شده باشه و کاربر (یا گوگل) مجبور باشه از چند مسیر مختلف رد بشه تا پیداش کنه، هم تجربه کاربری ضعیف میشه، هم احتمال اینکه گوگل به اون صفحه برسه کمتر میشه.

به همین خاطر، یکی از اصول مهم در سئو اینه که صفحاتی که ارزش بالایی دارن، توی عمق کمتر (حداکثر ۳ تا ۴ کلیک) قرار بگیرن تا هم کاربر سریعتر به هدفش برسه و هم گوگل مؤثرتر بخزه.

هرچی فاصله بین صفحات کمتر باشه، هم کارایی خزش بالاتر میره، هم تجربه کاربری بهتر میشه. موتورهای جستجو منابع خزش خودشون رو بین صفحات سایت تقسیم میکنن. خزندهها باید منابع محدودشون رو صرف مهمترین صفحات سایت کنن. خزندهها هم درست مثل کاربرا، منابع و زمان محدودی دارن. معمولا هم به محتواهایی سر میزنن که دم دستتر، قابل فهمتر و دسترسی بهشون راحتتره.

اما صفحههایی که ته ساختار سایت دفن شدن یا از منوها و لینکهای پیچیده عبور میخوان، معمولا نادیده گرفته میشن.

تفاوت عمق خزش (Crawl Depth) و عمق صفحه (Page Depth)

قبل از اینکه بریم روشهای سراغ بررسی عمق خزش، لازمه یه تفاوت مهم رو بدونین؛ چون خیلی وقتا این دوتا اشتباه گرفته میشن 👇

عمق صفحه (Page Depth) مربوط به کاربره.

یعنی نشون میده کاربر از صفحه اصلی چند تا کلیک باید بزنه تا برسه به یه صفحه خاص.

در واقع مسیر کوتاهترین راه از صفحه اصلی تا اون صفحهست.

مثلاً:

- صفحه اصلی همیشه عمق ۰ داره

- صفحاتی که مستقیما بهش وصلن، عمق ۱ دارن

- صفحات بعدی میشن عمق ۲، ۳ و همینطور پایینتر

اما عمق خزش (Crawl Depth) به گوگل و رباتهای خزنده مربوطه.

اینجا دیگه بحث کاربر نیست، بلکه موضوع اینه که ربات از چه مسیری و با چند لینک داخلی به یه صفحه میرسه.

ممکنه یه صفحه از نظر کاربر در عمق ۳ باشه، ولی چون از منوی فوتر یا یه مقاله دیگه بهش لینک دادین، برای ربات گوگل مسیرش کوتاهتر بشه و عمق خزشش کمتر محاسبه بشه.

به زبون سادهتر:

- Page Depth = مسیر کاربر

- Crawl Depth = مسیر ربات

حالا چرا این دوتا مهمن؟

چون ارتباط مستقیمی با هم دارن.

هرچی ساختار سایتتون منطقیتر باشه و لینکسازی داخلیتون اصولیتر انجام بشه، عمق صفحهها کمتر میمونه و در نتیجه ربات گوگل هم راحتتر به اون صفحات میرسه . یعنی عمق خزش هم کاهش پیدا میکنه.

در ادامه، برای اینکه دقیقتر بفهمین عمق صفحه و عمق خزش تو سایت شما چقدره و چطور میتونین اونها رو بهینه کنین، قراره با دو تا ابزار خیلی کاربردی کار کنیم 👇

با میزفا تولز یاد میگیرین چطور عمق صفحه رو ببینین و فیلتر کنین.

و با Screaming Frog بررسی میکنیم عمق خزش هر صفحه چقدره و چطور میشه اون رو تحلیل کرد.

قبل از ورود به بررسی جزئی و پیدا کردن صفحات با عمق خزش زیاد در ابزار خزش سایت -> تب نمای کلی یک دید کلی از نحوه توزیع عمق خزش میتونید به دست بیارید.

چطور عمق خزش و عمق صفحه رو بررسی کنیم؟

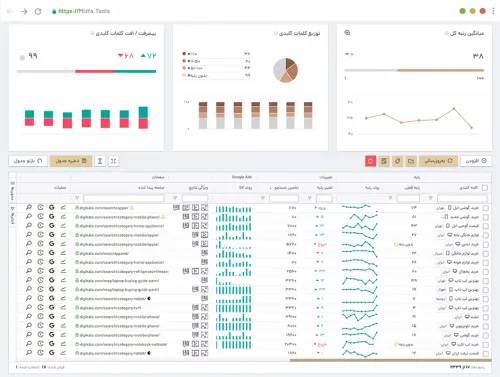

۱. بررسی عمق صفحه با تب صفحات خزش سایت میزفا تولز

- وارد ابزار خزش سایت میزفا تولز شید.

- آدرس سایت مورد نظر رو وارد کنین و دکمهی خزش جدید رو بزنین تا ابزار سایت رو بخزه.

- بعد از اتمام خزش، از منوی ابزار روی تب صفحات کلیک کنین.

- این تب لیست کامل URLها و متادیتاهای هر صفحه رو نمایش میده. از جمله ستون عمق صفحه (Page Depth).

- در بخش فیلتر جستجو روی گزینهی عمق صفحه کلیک کنین.

- شرط رو بذارین: عمق بزرگتر مساوی ۴ و اعمال کنین.

- ابزار فقط صفحاتی که عمقشون ۴ یا بیشتره رو نمایش میده.

اگه میخواین هر عمق خاصی رو ببینین (مثلا دقیقا عمق 2 یا بین 2 تا 3)، همون فیلتر رو باز کنین و شرط مورد نظرتون رو تنظیم کنین.

با این روش میتونین سریع دستههای مختلف صفحات (مثلا صفحات خیلی عمیق، صفحات سطح میانی، یا صفحات نزدیک به homepage) رو جدا کنین و تحلیل کنین.

پیشنهاد عملی بعد از اعمال فیلتر مورد نظر

- خروجی بگیرین. فایل CSV یا Excel از لیست صفحات عمق ≥4 استخراج کنین.

- صفحات حیاتی که عمق بالایی دارن (مثل صفحات دستهبندی مهم یا صفحات محصولات پرفروش) رو اولویتبندی کنین.

- برای هر صفحه برنامه اصلاح بنویسین:

- افزودن لینک داخلی از صفحات سطح بالا (مثلا از دستهبندی به محصول)،

- قرار دادن بنر یا CTA در صفحه اصلی،

- یا ایجاد صفحات میانجی (مثل صفحات مجموعه/لندینگ) که مسیر را کوتاهتر کنن.

۲. بررسی عمق صفحه با تب فهرست بازبینی خزش سایت میزفا تولز

یکی از سریعترین راهها برای پیدا کردن صفحات خیلی عمیق، سر زدن به تب فهرست بازبینی هست. این تب سه ستون داره:

خطاها — هشدارها — اطلاعیهها.

تو ستون اطلاعیهها یه گزینه هست به اسم «صفحات با عمق زیاد». اگه روش کلیک کنین، ابزار بهصورت فیلتر شده فقط همون صفحات عمق بالا رو نشون میده.

چطور ازش استفاده کنین

- وارد ابزار خزش سایت بشین و خزش جدید اجرا کنین.

- بعد از اتمام خزش، از منوی ابزار تب فهرست بازبینی رو باز کنین.

- ستون هشدارها رو نگاه کنین و روی «صفحات با عمق زیاد» کلیک کنین.

- لیستی از URLها نمایش داده میشه. اینها صفحاتی هستن که بهصورت خودکار توسط ابزار بعنوان «عمق زیاد» تشخیص داده شدن.

- خروجی بگیرین (CSV/Excel) و طبق اولویتبندی بررسی و اصلاح کنین.

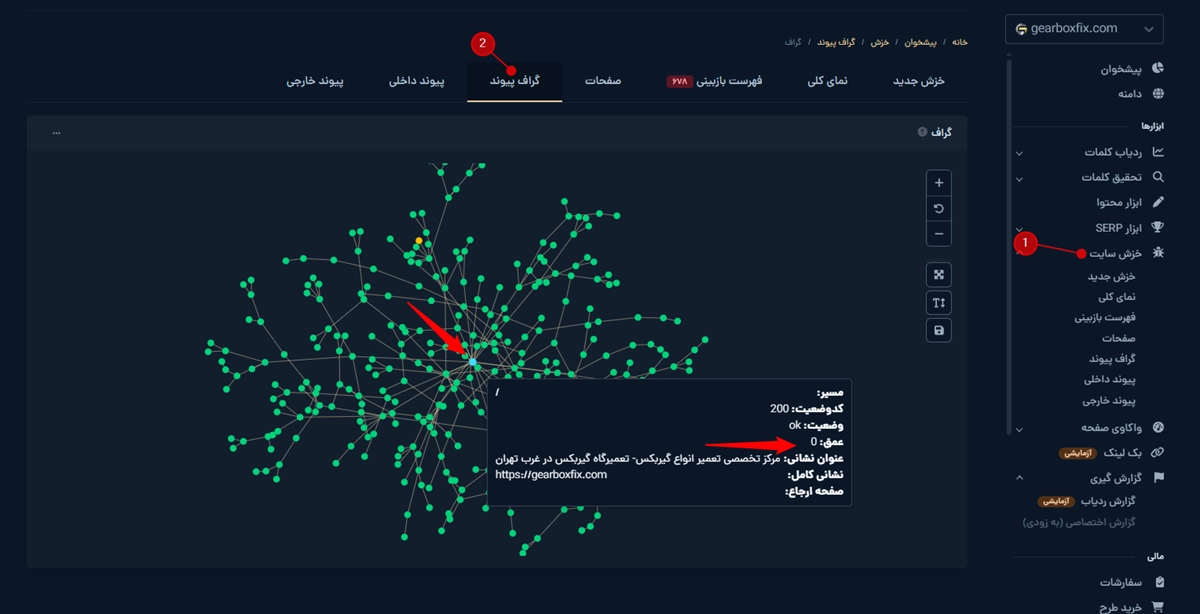

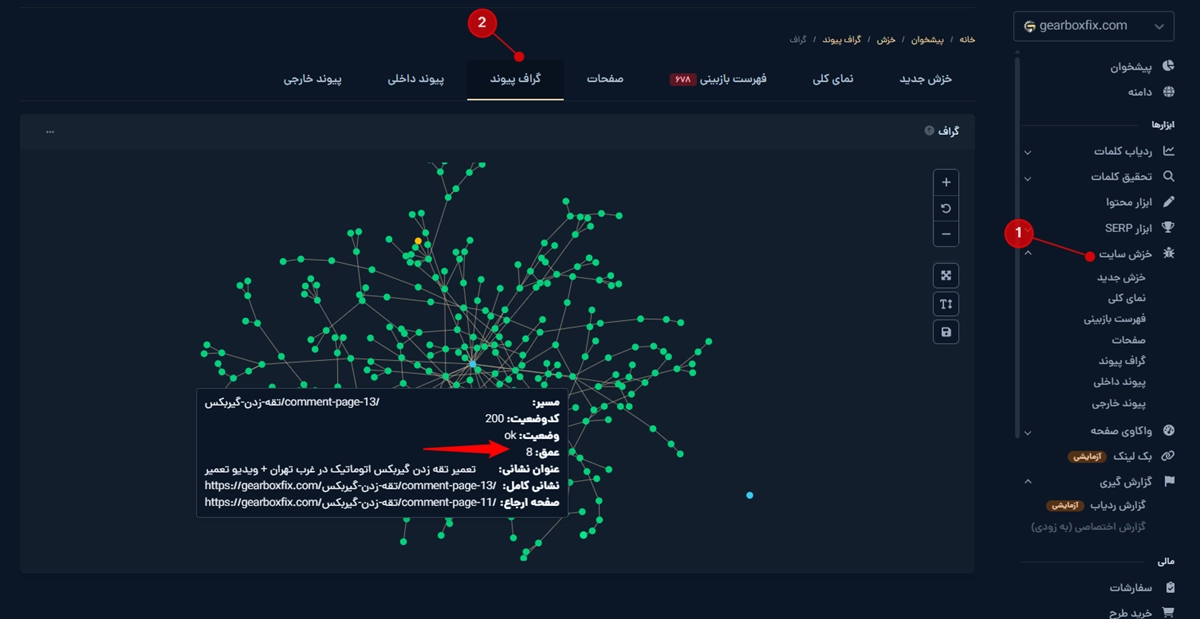

۳. بررسی عمق صفحه با تب گراف پیوند میزفا تولز

اگه بخواین عمق صفحات سایتتون رو بهصورت بصری و کاملا واضح ببینین، بهترین قسمت ابزار تب گراف پیوند در ابزار خزش سایت میزفا تولزه.

این تب یه نقشهی گرافی کامل از لینکسازی داخلی شما میسازه.

اینجا دقیقا میتونین چشمتون ببینه که هر صفحه در چه عمقی قرار گرفته و چقدر از صفحه اصلی فاصله داره.

چطور عمق صفحه رو از گراف پیوند بررسی کنیم؟

۱. اول از همه وارد ابزار خزش سایت بشین و اجازه بدین سایت کامل کرال بشه.

۲. بعد از پایان خزش، وارد تب گراف پیوند بشین.

۳. الان یه گراف بزرگ پر از گره یا دایره میبینین که ساختار کامل لینک داخلی سایتتونه.

۴. وقتی روی هر گره کلیک کنین، باکس اطلاعات باز میشه که شامل موارد زیره:

- مسیر صفحه

- کد وضعیت

- وضعیت لینکدهی

- عمق صفحه

- لینک ارجاعدهنده

- عنوان صفحه

این قسمت چرا خیلی مهمه؟

چون بر خلاف لیست جدولمانند، اینجا میتونین:

- سریع بفهمین کدوم بخشهای سایت خیلی پراکنده شدن.

- کدوم صفحات خیلی دور افتادن و در عمق زیادن.

- کدوم خوشههای محتوا لینکسازی خوبی دارن و کدومها ندارن.

- ساختار سایتتون از دید گوگل دقیقا چه شکلیه.

در ضمن از مجموعه مقالات آموزش تخصصی سئو مقاله مربوط به گراف پیوند رو مطالعه کنید تا یاد بگیرید چطور ساختار لینکسازی داخلی سایت رو با میزفا تولز تحلیل کنید.

۴. بررسی عمق خزش با ابزار اسکریمینگ فراگ

مرحله اول: اجرای خزش سایت

- اول از همه آدرس سایت رو داخل ابزار Screaming Frog وارد کنین و اجازه بدین کامل بخزه.

- بعد از اینکه خزش تموم شد، از پنل سمت راست برید سراغ بخش Site Structure.

- تو این قسمت، یه نمودار کلی میبینین که عمق خزش صفحات رو بهصورت تصویری نشون میده. یعنی دقیقا مشخص میشه چند تا از صفحات در عمق ۱ هستن، چند تا در عمق ۲، ۳ و بالاتر.

مرحله دوم: بررسی دقیق در جدول صفحات

حالا اگه بخواین جزئیتر بررسی کنین، کافیه به جدول اصلی URLها برین.

توی این جدول، ستونی با عنوان Crawl وجود داره که درگ کنید و در کنار ستون URLها قرار بدید.

اینجا میتونین دقیق ببینین هر صفحه در چه عمقی قرار گرفته و حتی صفحات مهمی که عمق بالایی دارن رو شناسایی کنین تا بعداً برای بهینهسازی لینکسازی داخلی روی اونها کار کنین.

به همین راحتی با چند تا کلیک، میتونین کل ساختار سایتتون رو از دید گوگل بررسی کنین و بفهمین کدوم صفحات بیش از حد عمیقن و نیاز دارن به صفحه اصلی یا صفحات بالاتر نزدیکتر بشن.

پیشنهاد عملی بعد از خروجی گرفتن از اسکریمینگ فراگ

حالا بعد از اینکه با اسکریمینگ فراگ ساختار سایت و عمق خزش رو دیدین، وقتشه یه قدم جلوتر برید و تحلیلش کنین.

urlهایی که عمق خزش بزرگتر و مساوی ۴ دارن رو فیلتر کنین و از اسکریمینگ فراگ خروجی بگیرین.

اگه سایتو خوب نمیشناسین، بهتره در کنارش خروجی سرچ کنسول رو هم بیارین تا یه دید واقعی از عملکرد صفحات داشته باشین.

اینجاست که بخش جذاب ماجرا شروع میشه 👇

میبینیم یهسری صفحات تو عمق ۴ و بالاتر از ۴ قرار دارن، اما کلی کلیک و ایمپرشن دارن!

و اینجاست که باید از خودمون بپرسیم:

«چرا به این صفحات لینک ندادم؟ چرا هنوز اینقدر از دید رباتها و کاربرا دورن؟»

اینجا نباید عجله کنیم و شروع کنیم الکی لینک دادن به هر صفحهای.

اینکه یه صفحه ارزش لینک گرفتن داره یا نه، بستگی به ساختار سایت و اهمیت اون صفحه داره.

پس باید یه نگاه دقیقتر بندازیم و فکر کنیم:

کجا توی ساختار سایتم جای لینک دادن به این صفحات خالیه؟

آیا باید از صفحهی کتگوری بالادستی لینک بدم؟ یا از یه مقاله مرتبط؟

هدف اینه که ساختار سایت تمیز و هدفمند بمونه.

نه اینکه فقط بخوایم با چند تا لینک مشکل رو ظاهرا حل کنیم.

بهصورت خلاصه:

با ترکیب دادههای اسکریمینگ فراگ و سرچ کنسول، میتونین بفهمین کدوم صفحات مهم ولی عمیق هستن،

و با یه بازطراحی لینکسازی داخلی، اونها رو به مسیر اصلی سایت نزدیکتر کنین تا هم گوگل راحتتر بهشون برسه، هم کاربر.

چطور میتونیم بهرهوری خزش سایت رو بالا ببریم؟

۱. بهروزرسانی منظم نقشه سایت (Sitemap)

یکی از سادهترین ولی مؤثرترین کارهایی که میتونین برای افزایش بهرهوری عمق خزش (Crawl Depth) انجام بدین،

همین بهروزرسانی منظم نقشه سایته.

نقشه سایت (XML Sitemap) درواقع مثل یه نقشه راه برای گوگله که بهش میگه چه صفحاتی تو سایت وجود دارن و کدومها مهمترن.

وقتی این نقشه رو منظم و بهروز نگه دارین، گوگل خیلی سریعتر میفهمه چی تازه به سایتتون اضافه شده یا چی حذف شده.

اما نکته مهم اینجاست 👇

نقشه سایتتون باید دینامیک (Dynamic) باشه، یعنی بهصورت خودکار با تغییرات سایت بهروز بشه.

مثلا هر بار که یه محصول جدید اضافه میکنین، یه مقاله منتشر میکنین، یا بخشی از سایتو تغییر میدین،

نقشه سایت هم باید این تغییرات رو منعکس کنه.

📌 توصیه من اینه که بعد از هر تغییر مهم، نقشه سایت رو بررسی کنین و مطمئن بشین گوگل به نسخه جدیدش دسترسی داره.

مخصوصا اگه صفحات جدید براتون ارزشمند هستن و میخواین سریعتر ایندکس بشن.

۲. بهبود ساختار و ناوبری (Navigation) سایت

بهبود ساختار و ناوبری سایت یکی از اون کارهای پایهایه که هم روی تجربه کاربری تأثیر مستقیم داره، هم روی بهرهوری خزش. یعنی با یه تیر، دوتا نشون میزنین🎯

وقتی ساختار سایتتون منظم و قابل فهم باشه، هم کاربرا سریعتر مسیر خودشونو پیدا میکنن، هم موتورهای جستجو راحتتر صفحات مختلف رو شناسایی و ایندکس میکنن.

🧭 منوی ناوبری (Navigation Menu) رو ساده و منطقی طراحی کنین

اولین قدم، داشتن یه منوی مرتب و هدفمنده.

از منوهای شلوغ و تودرتو که کاربر رو گیج میکنن، فاصله بگیرین.

بهجاش محتواها رو به شکل دستهبندی منطقی و لایهلایه بچینین. تا کاربر بدونه با کلیک روی هر گزینه قراره چی ببینه.

📂 ساختار لینکدهی داخلی رو تقویت کنین

ناوبری فقط منو نیست!

لینکهای داخلی هم بخش مهمی از ناوبری محسوب میشن.

پس مطمئن بشین که بین صفحات مرتبط لینک وجود داره تا رباتهای گوگل بتونن مسیرهای مختلف رو راحتتر بخزن و صفحات عمیقتر سایتتون هم شانس ایندکس شدن پیدا کنن.

۳. ساختار سلسلهمراتبی بسازین

یکی از مهمترین کارایی که باید تو طراحی سایت انجام بدین، اینه که یه ساختار درختی و منظم برای کل صفحاتتون بسازین.

یعنی چی؟ یعنی بدونین هر صفحه دقیقا کجای این درخت قرار میگیره.

در حالت ایدهآل، ساختار سایت باید به شکل زیر باشه 👇

- در بالاترین سطح: دستهها (Categories)

- زیر اونها: زیردستهها (Subcategories)

- و در نهایت: صفحات جزئیتر یا محصولها (Detail Pages)

این نظم باعث میشه خزندههای گوگل دقیقتر بفهمن هر صفحه چه جایگاهی داره و چطور به بقیه صفحات مربوط میشه.

در نتیجه، هم ایندکس شدن سریعتر اتفاق میافته،

هم عمق خزش کنترلشدهتر و بهینهتری خواهید داشت.

📌 یادتون نره: ساختار سایت مثل نقشهی گوگله هر چقدر تمیزتر طراحی بشه، گوگل مسیرها رو سریعتر و هوشمندانهتر یاد میگیره.

در ضمن برای اینکه ساختار سایتتون رو طراحی کنید حتما اول رقیبهاتون رو شناسایی کنید و بعد ساختار سایتشون رو آنالیز کنید و ببینید ساختار سایتشون رو چطور چیدن، ازشون ایده بگیرید چون اونها این مسیر رو رفتن و آزمون و خطا کردن.

۴. از مسیرنمای کاربر یا Breadcrumb استفاده کنین

Breadcrumb یا همون مسیرنمای کاربر، یه عنصر سادهست اما تأثیر فوقالعادهای روی ساختار سایت و درک گوگل از صفحات داره.

با اضافه کردن مسیرنما، هم کاربر راحتتر میتونه بفهمه الان دقیقا کجای سایت قرار داره، و هم موتورهای جستجو بهتر متوجه ساختار سلسلهمراتبی صفحات شما میشن.

مثلا فرض کن مسیر صفحهای از سایت شما اینطوری باشه 👇

صفحه اصلی ← مقالات ← آموزش سئو ← عمق خزش در سئو

این یعنی هم کاربر میتونه با یه کلیک برگرده به مرحلهی قبل، و هم گوگل متوجه میشه که صفحهی «عمق خزش در سئو» زیرمجموعهی بخش «آموزش سئو» قرار گرفته.

📌 در نتیجه، اضافه کردن بردکرامب هم تجربه کاربری (UX) رو بهتر میکنه

و هم به بهینهسازی ساختار لینکها و افزایش بهرهوری خزش کمک میکنه.

۵. آدرس صفحات (URLها) رو بهینه کنین

یکی از سادهترین ولی مؤثرترین کارها برای بهبود بهرهوری خزش، همین بهینهسازی آدرس صفحاته.

آدرس (URL) هر صفحه باید کوتاه، تمیز و تا حد ممکن توصیفی باشه، چیزی که هم برای کاربر قابل فهم باشه، هم برای رباتهای گوگل.

📍 مثلا بهجای این مدل آدرسهای پیچیده و بیمفهوم:

example.com/post?id=12345

بهتره از ساختار منطقی و خوانا استفاده کنین، مثل:

example.com/seo/crawl-depth

این نوع URL نهتنها برای موتورهای جستجو قابل درکه، بلکه به کاربر هم حس اعتماد و نظم میده.

۶. اضافه کردن لینکهای داخلی (Internal Links)

لینکهای داخلی، مثل مسیرهای فرعی توی یه شهر هستن 🚦

هرچی این مسیرها واضحتر و بیشتر باشن، هم کاربرا راحتتر جاهای مختلف سایت رو پیدا میکنن و هم گوگل میتونه بهتر بین صفحات حرکت کنه و همهجا رو ببینه.

وقتی شما بهصورت هدفمند داخل محتوا لینک میدین، در واقع دارین برای رباتهای موتور جستجو نقشه راه میکشین.

یعنی میگین: “از این صفحه برو اون یکی، اونجا هم چیزای مهمتری هست!”

اگر بین صفحات سایتتون لینک داخلی کافی وجود نداشته باشه، بهخصوص لینکهایی که به صفحات عمیقتر اشاره دارن، رباتهای جستجو مسیر کافی برای رسیدن به اون صفحات نخواهند داشت.

در نتیجه، اون بخشها کمتر خزیده و ایندکس میشن.

📌 مزایای لینکسازی داخلی:

- باعث میشه فعالیت خزش گوگل بین صفحات بهتر توزیع بشه و بعضی صفحات نادیده گرفته نشن.

- کمک میکنه رباتها تا عمق بیشتری از سایت برن و صفحات زیرین هم شانس ایندکس شدن پیدا کنن.

- وقتی صفحات مهم از چند جای مختلف لینک میگیرن، گوگل متوجه میشه که اون صفحات ارزش بیشتری دارن و باید سریعتر ایندکس بشن.

🔍 نکته حرفهای:

برای لینکهای داخلی از انکرتکستهای طبیعی و مرتبط استفاده کنین (این موضوع واقعا مهمه که با انکر تکست صحیح لینک بدین دست کم نگیرینش).

مثلا بنویسین:

سئو محلی

نه اینکه فقط بگین:

اینجا کلیک کنید! 😅

با همین تغییر ساده، هم تجربه کاربری بهتر میشه، هم سیگنالهای سئو دقیقتر به گوگل منتقل میشن.

اما یه چیز خیلی مهمتر هم هست که نباید ازش غافل بشین:

صفحات یتیم (Orphaned Pages)

حتما صفحات یتیم سایتتون رو پیدا کنین!

صفحات یتیم همون صفحاتی هستن که هیچ لینکی از هیچ جای دیگه سایت بهشون داده نشده.

یعنی کاملا تنها موندن 😅

وقتی یه صفحه از ساختار سایت جدا باشه، گوگل بهسختی میتونه پیداش کنه یا حتی ممکنه هیچوقت ایندکسش نکنه.

بنابراین حتما این صفحات رو شناسایی و براشون مسیر درست بسازین.

یه لینک از منو، یه لینک از مقاله مرتبط، یا حتی از فوتر سایت میتونه نجاتش بده.

پیدا کردن صفحات یتیم با میزفا تولز:

- وارد ابزار خزش سایت بشید. آدرس سایت رو وارد کنید تا خزش انجام بشه

- وارد تب فهرست بازبینی بشید.

لینکهای شکسته و زنجیرههای ریدایرکت (Broken Links & Redirect Chains)

یکی از اشتباهات رایج تو لینکسازی همینه.

وقتی لینکی شکسته باشه یا چندتا ریدایرکت پشت سر هم وجود داشته باشه، رباتهای گوگل با بنبست یا مسیر حلقوی مواجه میشن 🚧

یعنی نمیتونن ادامه بدن و صفحات پایینتر رو ببینن.

نتیجه؟ بخشی از سایت اصلاخزش یا ایندکس نمیشه.

حتما هر چند وقت یه بار لینکهای شکسته و زنجیرههای ریدایرکت رو پیدا و اصلاح کنین. هیچوقت به لینکهای ریدایرکت شده لینک ندین.

۷. بهبود عملکرد سایت (Improve Website Performance)

یکی از مؤثرترین راهها برای افزایش بهرهوری خزش، اینه که سایتتون سریع و سبک باشه.

هرچی صفحات زودتر بارگذاری بشن، رباتهای گوگل هم میتونن در زمان کمتر، تعداد بیشتری از صفحات رو بخزن و ایندکس کنن.

یعنی با یه تیر، چند تا نشون 🎯

✅ نکات کلیدی برای افزایش سرعت سایت:

- بهینهسازی تصاویر:

قبل از آپلود، تصاویر رو فشرده کنین تا حجم بارگذاری کمتر بشه (سایتهای کاهش حجم عکس). - کاهش درخواستهای HTTP:

فایلهای اضافی مثل اسکریپتها، فونتها و استایلهای غیرضروری رو حذف کنین. - بهبود زمان پاسخ سرور (Server Response Time):

مطمئن بشین سرورتون سریع جواب میده و تاخیر نداره. - استفاده از کش (Caching) و CDN:

این دو ابزار کمک میکنن بار روی سرور کمتر بشه و محتوا سریعتر به کاربر برسه.

اگر سایت وردپرسی دارید یک یاز افزونههای کاربردی برای افزایش سرعت سایت افزونه WP RACKET هست. حتما بررسیش کنی کلی ویدیوهای آموزشی هم میتونید تو یوتیوب پیدا کنید درموردش😊

در ضمن در مجموعه مقالات آموزش تخصصی سئو ما ۳۳ مقاله در زمینه آموزش افزایش سرعت سایت نوشتیم که خوندنشون خالی از لطف نیست.

وقتی سایت سریع و واکنشگرا باشه، گوگل تو همون محدودهی بودجه خزش خودش میتونه صفحات بیشتری رو ایندکس کنه.

در نتیجه، محتوای مهمتر شما زودتر دیده میشه و احتمال رتبه گرفتنش بالاتر میره.

🔹 نکته مثبت:

امروزه بیشتر سیستمهای مدیریت محتوا (CMS) مثل وردپرس قالبهایی دارن که هم برای موبایل بهینهان، هم سبک و سریع اجرا میشن.

پس فقط کافیه مطمئن بشین از یه قالب استاندارد و بهینه استفاده میکنین.

۸. تست کنین ببینین رباتها با محتوای جاوااسکریپتی چیکار میکنن

با دنیای وب مدرن، جاوااسکریپت شده قهرمان ساخت سایتهای تعاملی😄

ولی یه نکتهی مهم هست: همهی موتورهای جستوجو (مثل گوگل، بینگ و…) به یه اندازه تو فهمیدن جاوااسکریپت قوی نیستن. بعضیاشون هنوز تو رندر کردن این نوع محتوا گیر میکنن.

اولین قدم اینه که مطمئن شین محتوای صفحههاتون برای رباتها قابل دسترسی و رندرشدنه.

پس هر از گاهی تست کنین ببینین آیا بخشهایی که با جاوااسکریپت لود میشن، واقعا برای گوگل قابل مشاهده هستن یا نه.

ابزار پیشنهادی:

- از ابزار URL Inspection توی Search Console استفاده کنین.

- روی Test Live URL کلیک کنید.

- روی view tested page کلیک کنید.

- روی screenshot کلیک کنید.

- در اینجا میتونید ببینید رباتهای گوگل شما رو به چه شکلی میبینن.

اگه با بینگ هم کار میکنین، ابزار مشابهش توی Bing Webmaster Tools در دسترسه.

۹. محتوای رندرشده رو برای رباتها ساده کنین

همهمون میدونیم رباتهای گوگل مثل ما آدما نیستن 😅

اونها نمیتونن تصاویر، ویدیوها یا افکتهای خاص سایت رو مثل یه کاربر واقعی ببینن. برای درک محتوا، فقط به متن جایگزین تصویر (alt text)، نام فایلها و کد HTML تکیه میکنن.

پس اگه میخواین گوگل محتوای شما رو درست بخزه و ایندکس کنه، باید راه رو براش هموار کنین.

یعنی:

- از تصاویر با نام فایل و alt توصیفی استفاده کنین.

- از عناصر خیلی پیچیده یا جلوههای تصویری اضافی توی بکگراند و طراحی صفحه خودداری کنین.

- مطمئن شین محتوا حتی بدون استایل یا جاوااسکریپت هم قابل درکه.

📌 یادتون باشه: هرچقدر محتوای صفحهتون برای رباتها سادهتر و قابلفهمتر باشه، خزیدن و ایندکس شدنش هم سریعتر انجام میشه.

جمعبندی: عمق خزش بهینه = ایندکس هوشمندانهتر

عمق خزش (Crawl Depth) خوب باعث میشه گوگل ساختار سایت رو بفهمه.

هرچی مسیرها شفافتر و لینکها منظمتر باشن، گوگل راحتتر به لایههای عمیقتر سایت نفوذ میکنه و محتوای ارزشمندت سریعتر ایندکس میشه.

یادت باشه:

حتی اگه محتوای عالی بنویسی ولی ساختار لینکسازیت درست نباشه، گوگل شاید هیچوقت به اون صفحات نرسه!

پس ساختار لینکسازی داخلی رو جدی بگیر. چون این دقیقا همون جاییه که عمق خزش معنا پیدا میکنه و تفاوت بین یه سایت قوی و یه سایت گمشده در نتایج رو رقم میزنه.

در نهایت، هدف اینه که رباتهای گوگل بتونن بدون سردرگمی، از صفحهبهصفحهی سایتت عبور کنن و محتوای مهمت رو ببینن.

برای اینکه مطمئن شی این مسیر درسته، حتما با ابزار خزش سایت در میزفا تولز ساختار لینکهات، صفحات یتیم و مسیرهای خزش رو بررسی کن و قدمبهقدم عمق خزش سایتت رو بهینهتر بساز.

هدف اصلی از بهینهسازی عمق خزش (Crawl Depth) در سئو چیه؟

افزایش تعداد کلمات کلیدی در هر صفحه

کاهش فاصله صفحات مهم از صفحه اصلی برای خزش بهتر موتورهای جستجو

افزایش حجم محتوای صفحات برای جلب توجه خزندهها

جلوگیری از ایندکس شدن صفحات غیرضروری در سایت