خطای indexed though blocked by robots.txt چطوری حل کنم؟

خطای blocked by robots.txt در سرچ کنسول و در بخش Pages دیده میشه. این اخطار داره بهتون میگه با اینکه URL رو با فایل robots.txt مسدود کرده بودید، گوگل ایندکس کرده! توی این بخش از آموزش سرچ کنسول قراره بریم ببینیم مشکل از کجاست و چطور باید برطرفش کنیم.

علت خطای indexed though blocked by robots.txt در سرچ کنسول چیست؟

خیلی از صفحات سایت هستن که نیازی به ایندکس شدن ندارن و اگه جلوی ایندکس شدنشون رو نگیریم، بودجه خزش سایت رو بیهوده هدر میدن. ممکنه این صفحات رو از طریق فایل robots.txt مسدود کرده باشیم. یا حتی ممکنه تازه طراحی سایت رو شروع کرده باشیم و هنوز تکمیل نشده و نمی خوایم ربات های گوگل سایت رو بخزن و ایندکس کنن.

گوگل در بیشتر موارد وقتی می بینه توی فایل robots.txt دستور Disallow به کار بردید، به نظر شما احترام می ذاره؛ اما کار اونجایی خراب میشه که یکی به صفحه شما لینک داده باشه و ربات های گوگل URL مسدود شده شما رو با دنبال کردن لینک پیدا کنن. 😔

اینجا جاییه که گوگل URL رو ایندکس می کنه؛ حتی اگه شما قصد ایندکس کردنش رو نداشته باشید. اما لطف می کنه یه پیغام Warning یا اخطار میده بهمون که حواسمون باشه مشکل رو درست کنیم!

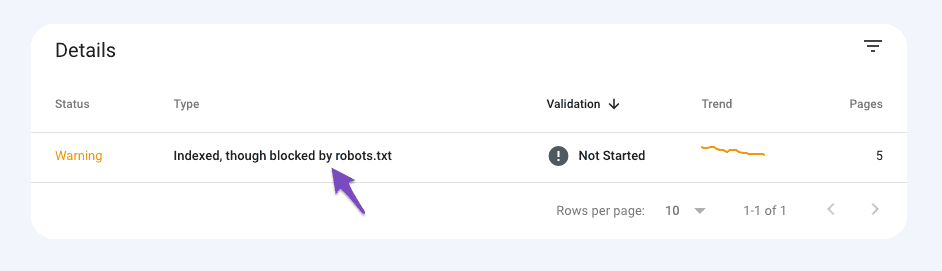

این خطا معمولا در بین لیست خطاهای سرچ کنسول به نسبت خطاهای دیگه، احتمال اتفاق افتادنش کمه؛ اما اگه اون رو در بخش Pages سرچ کنسول دیدید، باید هرچی زودتر به فکر راه برطرف کردنش باشید که در ادامه بهتون میگیم.

خطای indexed though blocked by robots.txt چطوری حل کنم؟

حالا که ربات های گوگل زحمت کشیدن صفحه ای که نمی خواستیم رو ایندکس کردن باید بریم سراغ راهکار. البته همین اول بگیم که همه تقصیرها گردن ربات های گوگل نیست. چون خود گوگل توی سند راهنمای سرچ کنسول بارها گفته برای جلوگیری از ایندکس بهتره از تگ noindex استفاده کنید.

در واقع URLهایی که در فایل robots.txt قرار میدیم از خزیدنشون جلوگیری میشه؛ اما گوگل برای ایندکس کردن صفحات، حتما همه URLها رو نمی خزه که در نهایت نتیجهاش میشه این مشکلی که در سرچ کنسول می بینیم.

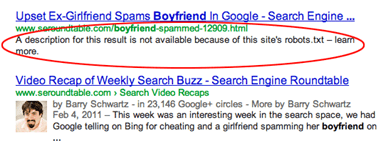

صفحه ای که از طریق robots.txt مسدود شده و ایندکس میشه با ظاهر زیر توی نتایج گوگل ظاهر میشه:

مرحله اول – پیدا کردن URLهای مشکل دار

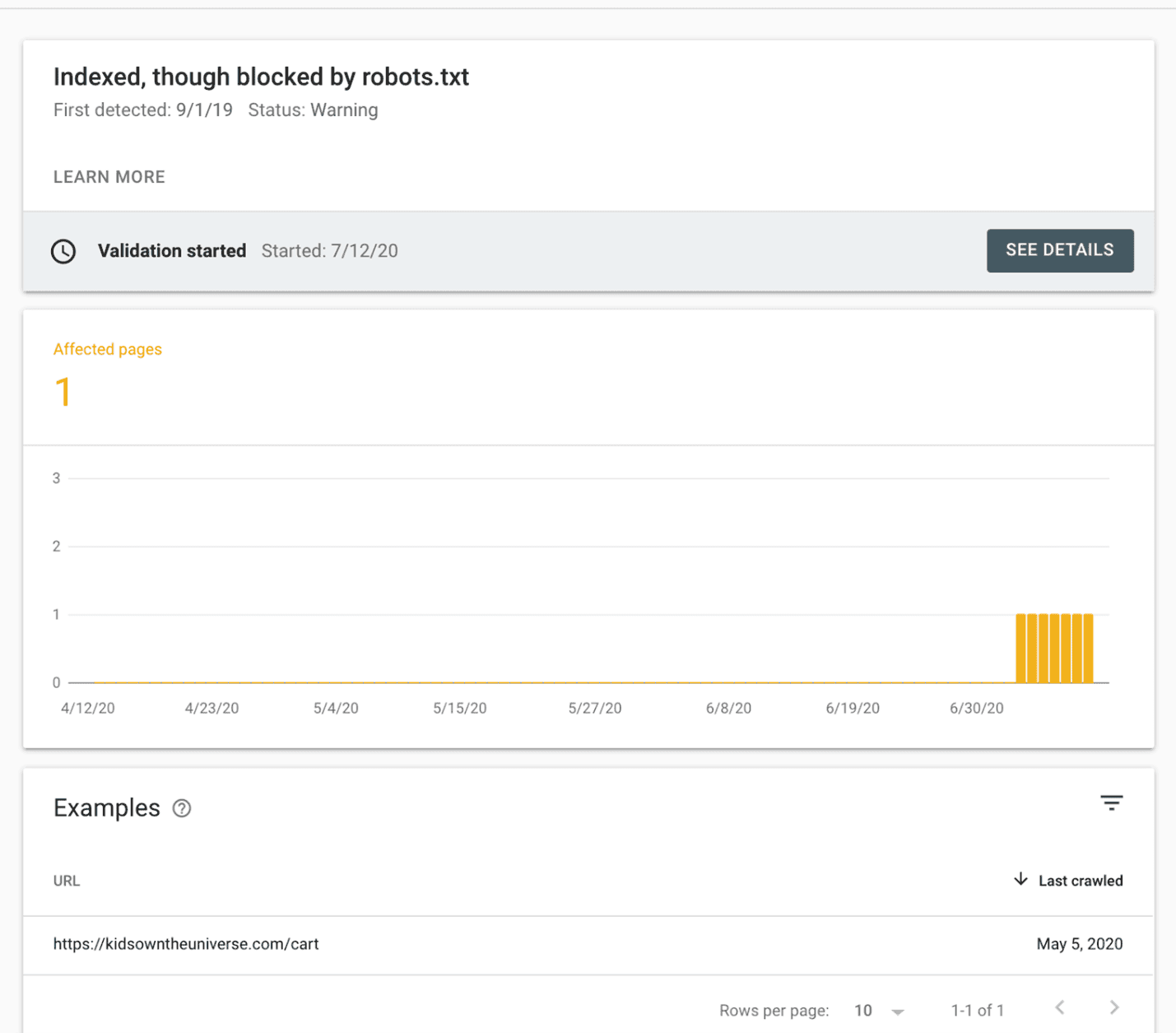

برای رفع خطای blocked by robots.txt در سرچ کنسول اول لیست URLهایی که این مشکل رو دارن، بررسی کنید. برای این کار کافیه روی ردیف مورد نظر در جدول گزارش Pages کلیک کنید تا به صفحه مربوط به URLهای مشکل دار برسید.

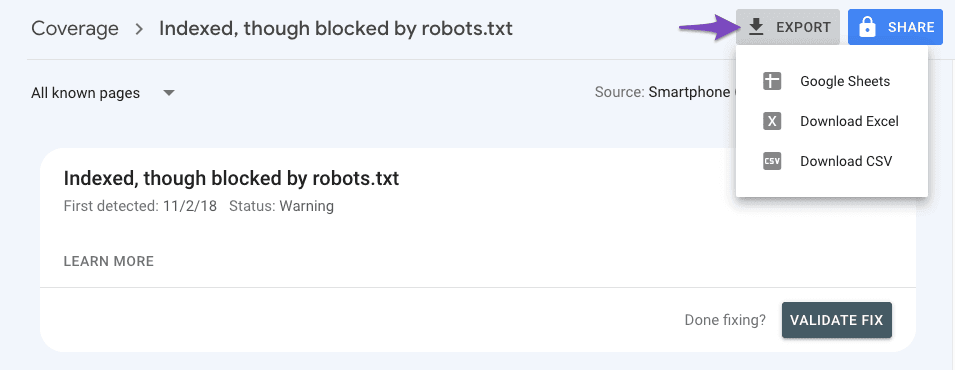

از بالای گزارش این صفحه می تونید از همه صفحاتی که اخطار blocked by robots.txt دارن خروجی بگیرید. بعد از خروجی گرفتن، دونه دونه URLها رو چک کنید و داخل مرورگر خودتون باز کنید.

نکته خیلی مهم: حواستون باشه سرچ کنسول همه URLهای سایت که با فایل robots.txt مسدود کرده بودید و ایندکس شدن رو بهتون نمایش نمیده. اگه دقت کنید بالای جدول URLها نوشته شده Examples که به معنی «نمونه» هست. یعنی سرچ کنسول فقط یک سری از صفحات سایت مشکل دار رو به عنوان نمونه در اختیارتون قرار میده.

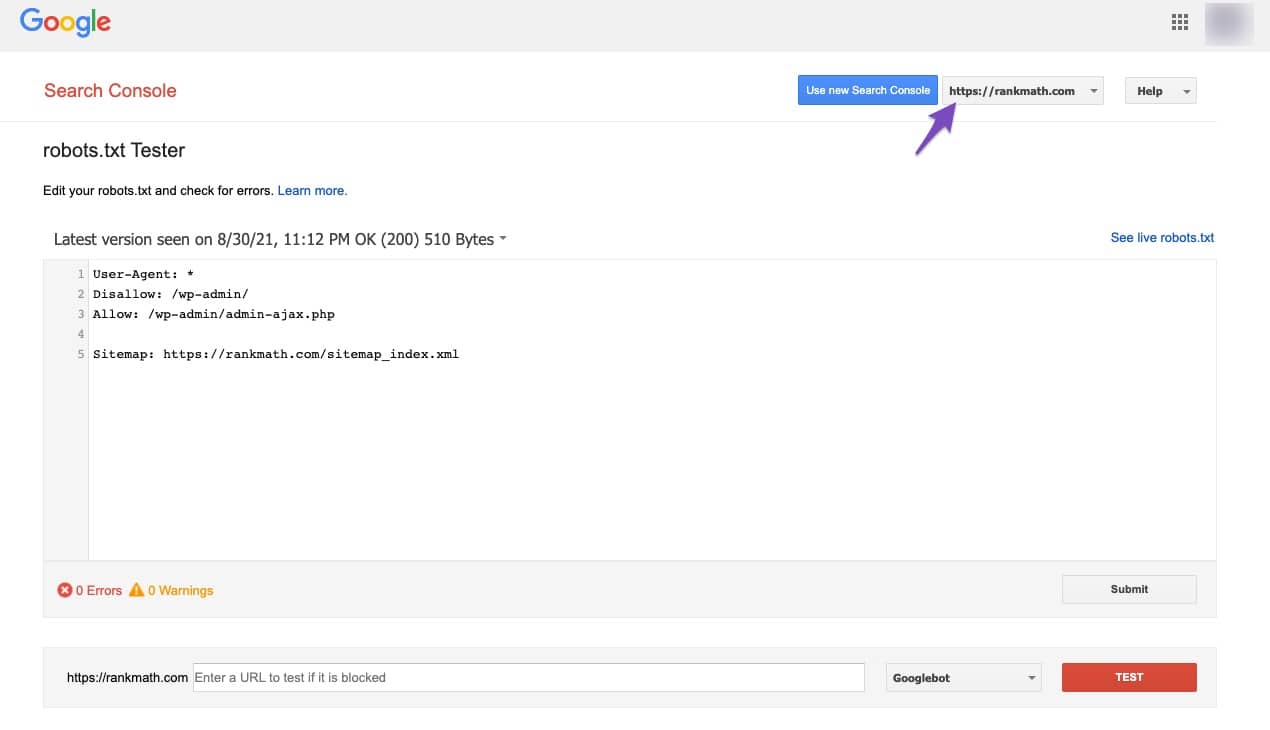

یک روش راحت وجود داره تا فایل robots.txt رو بررسی کنید و URLهای خاص رو باهاش چک کنید. ابزار robots.txt Tester برای این کار طراحی شده. کافیه Property (سایت) مورد نظر که در سرچ کنسول ثبت کردید رو انتخاب کنید تا این ابزار، فایل robots.txt رو نشون بده. 🧐

در بخش پایینی ابزار هم می تونید Path یا مسیرهای مربوط به سایت خودتون رو بررسی کنید تا مطمئن بشید جلوی خزش ربات های گوگل رو نمی گیرن.

مرحله دوم – تکلیف URLها رو مشخص کنید!

اگه صفحه ای بین URLها هست که می خواستید ایندکس بشه، فایل robots.txt خودتون رو بهروز کنید تا مشکلی برای این صفحات پیش نیاد.

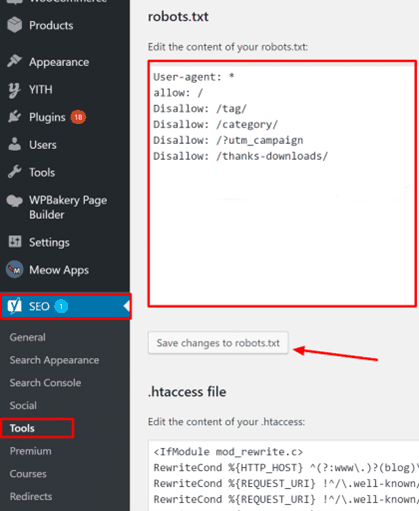

برای تغییر فایل robots.txt در سایت های وردپرسی می تونید از افزونه های سئو مثل یوآست و رنک مث استفاده کنید. در ابزار یوآست در بخش «ابزارها» و گزینه «ویرایشگر فایل» به robots.txt می رسید. در رنک مث هم در بخش «تنظیمات عمومی» یه گزینه برای ویرایش robots.txt هست. ✅

مابقی صفحاتی که نمی خواید ایندکس بشن باید با تگ noindex علامت گذاری بشن. برای اضافه کردن این تگ به صفحات باز هم می تونید از ابزارهای سئو استفاده کنید. افزونه هایی مثل رنک مث و یوآست در بخش تنظیمات مربوط به «عنوان ها و متاها» اجازه اضافه کردن تگ نو ایندکس رو میدن.

نکته: اگه می خواید ربات های گوگل با یک سری از صفحات سایت کاری نداشته باشن، بهترین راه استفاده از تگ نو ایندکس هست. وقتی این تگ رو به کار می برید ربات های گوگل صفحه رو می خزن و متوجه میشن خودتون گفتید نیازی به ایندکس نیست. اگه صفحات رو فقط با robots.txt مسدود کرده باشید، اجازه خزیدن ربات های گوگل رو گرفتید، اما ممکنه ربات ها با اطلاعات کمی که از لینک های هدایت کننده به URL پیدا می کنن، صفحه رو ایندکس کنن. 😕

مرحله سوم – تایید تغییرات در گوگل سرچ کنسول

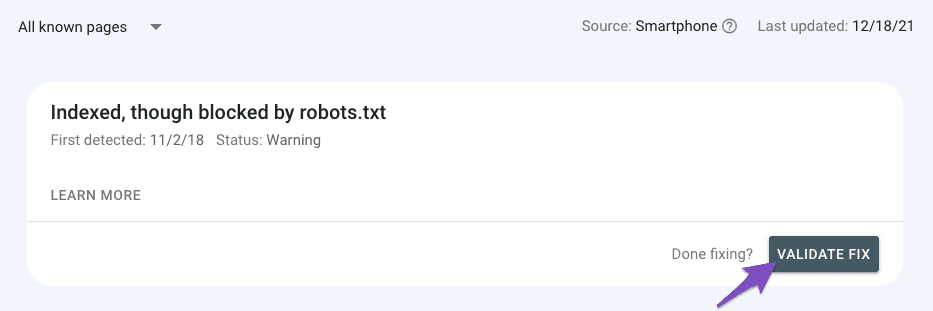

در نهایت برای اینکه جواب سوال «خطای indexed though blocked by robots.txt چطوری حل کنم» رو کامل کنیم باید به گوگل سرچ کنسول برگردید و روی دکمه طوسی رنگ Validate Fix کلیک کنید.

برای اینکه خطای blocked by robots.txt در سرچ کنسول و هر خطای دیگه ای برطرف بشه لازمه روی این دکمه ضربه بزنید تا گوگل بفهمه شما صفحات دارای مشکل رو بررسی کردید و مشکل رو رفع کردید. با این کار ربات های خزنده گوگل سریع تر به سراغ URLها میان و گزارش ها آپدیت میشه. 😉

لیست تمام صفحات نو ایندکس سایت رو چطور پیدا کنیم؟

همون طور که توی این مقاله اشاره کردیم، اگه می خواید بودجه خزش سایت رو بهینه کنید، بهتره از تگ Noindex به جای فایل robots.txt استفاده کنید. حالا یه سوال پیش میاد که چجوری بفهمیم کدوم صفحات رو نو ایندکس کردیم تا تگ رو به صفحات مورد نظرمون اضافه کنیم؟! 🤔

سرچ کنسول با پیغام Excluded by ‘noindex’ tag در بخش Pages یک سری از این صفحات رو در اختیارتون قرار میده. اما همه صفحاتی که تگ نو ایندکس دارن، در سرچ کنسول لیست نمیشه. برای پیدا کردن همه این صفحات باید به سراغ ابزارهای سئو بریم که تمام سایت رو می خزن و خطاهای سئو و موارد مهم رو به اطلاعمون می رسونن.

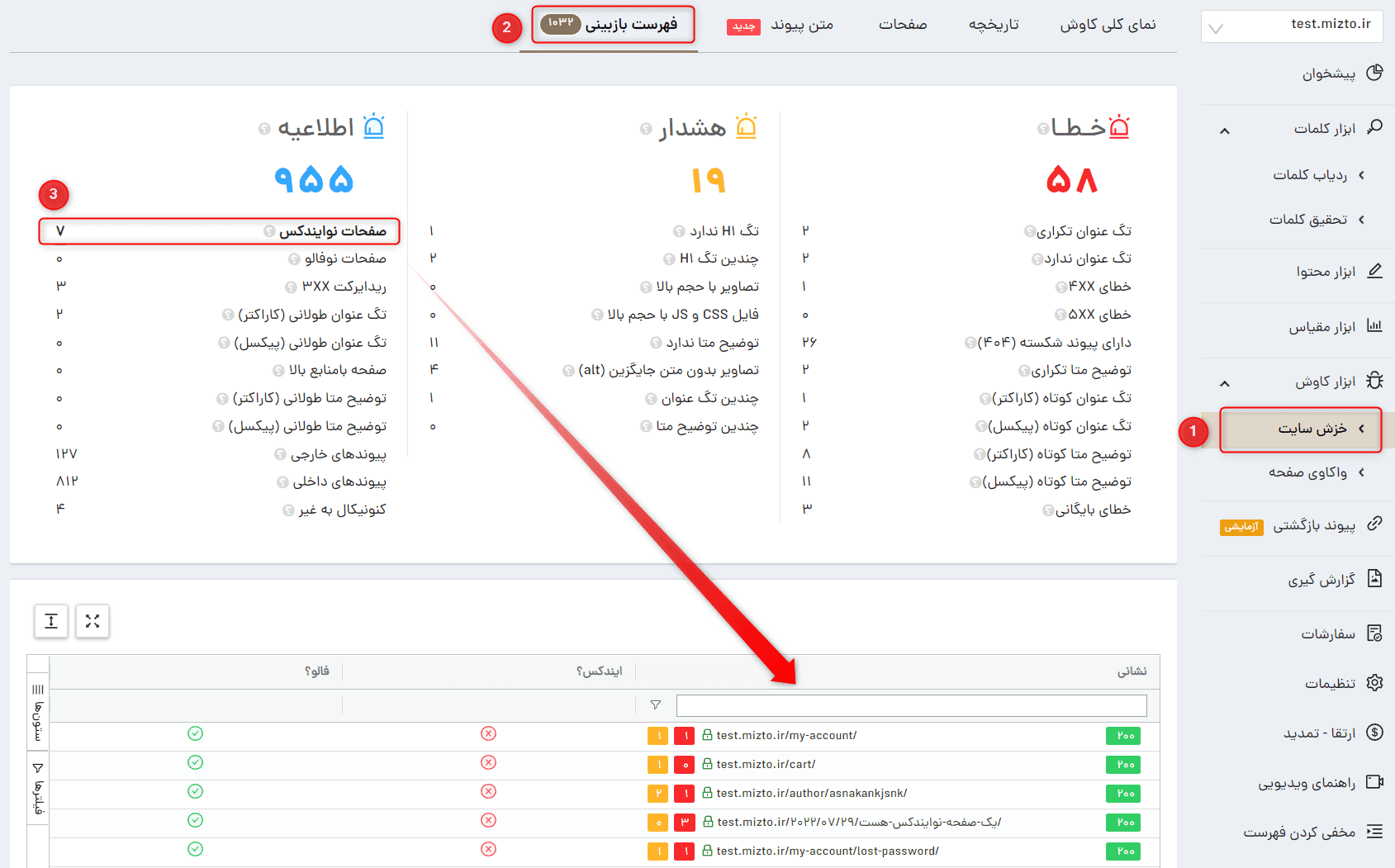

در ابزار خزش سایت میزفا تولز دقیقا همین امکان رو براتون طراحی کردیم تا هر زمان که نیاز دارید، کراولرهای میزفا تولز رو به سراغ سایت بفرستید و متوجه بشید توی کدوم صفحات از تگ noindex استفاده شده.

کافیه بعد از پایان خزش، وارد زبانه «فهرست بازبینی» این ابزار بشید و با کلیک روی گزینه «صفحات نو ایندکس» تمام صفحاتی که این تگ رو دارن پیدا کنید. حالا راحت می تونید این تگ رو به مابقی صفحات مورد نظرتون اضافه کنید.

میزفا تولز ابزار سئو ایرانی با 8 امکان دقیق و جذابه. برای آشنایی با ابزارهای میزفا تولز می تونید در سایت ثبت نام کنید و از فرصت 7 روز استفاده رایگان بهره ببرید. 😉

مشارکت کنندگان در این مقاله

همیشه عاشق کاوش و کشف جهان بودم؛ به همین خاطر خیلی زود به سمت علوم طبیعی کشیده شدم. سال ۱۳۹۱ وارد دانشگاه تهران شدم و جانورشناسی خوندم، اما دلم میخواست بیشتر کاوش کنم؛ تا روزی که اتفاقی مسیرم به دنیای خلق محتوا باز شد. از بهمن ۱۳۹۸ مشغول تولید محتوا برای سایتهای مختلف هستم. هر چقدر بیشتر پیش میرم عطش بیشتری برای کشف دنیاهای مختلف و خلق محتواهای مفید دارم. دوست دارم تجربهها و هرچیزی که یاد گرفتم رو به بقیه یاد بدم، چون هرچقدر بیشتر به هم یاد بدیم، جامعه بهتری خواهیم داشت. رویای من زندگی در جامعهای است که مردمش برای رشد هم بخیل نیستند، پس برای رشد مخاطبم بهترین محتوا رو خلق میکنم.